网站采集代码(网站采集规则)

admin 发布:2023-12-14 23:20 65

今天给各位分享网站采集代码的知识,其中也会对网站采集规则进行解释,如果能碰巧解决你现在面临的问题,别忘了关注本站,现在开始吧!

本文目录一览:

求抓取网页内容的程序或代码(两层或更多,delphi)

网页中特定窗口的文字,这个要根据具体特定窗口的类型来定,比如,如果是flash窗口,那么这个获取就比较困难。如果是普通的页面文字(全文字),可以用webbrowser控件或是其他网络控件(如tcpclient)获取。

其二,在Memo中也是在内存。其三,所有的TCP,HTTP都是把内容从Server端下载到本地,然后在客户端以某种格式呈现。其四,分析本地网页缓存,未必有用。COOKIES一是有时效,二是有安全方面的问题不好解决。这个问题太高级。

IE/webbrowser法:创建IE控件或webbrowser控件,结合htmlfile对象的方法和属性,模拟浏览器操作,获取浏览器页面的数据。优点:这个方法可以模拟大部分的浏览器操作。所见即所得,浏览器能看到的数据就能用代码获取。

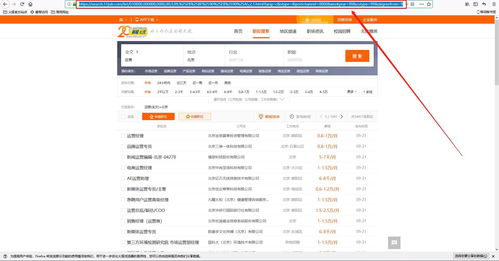

delphi编程,我想写一个程序。例如网页中有联系人,电话等信息,通过一个软件迅速提取数据并保存到数据库 例如一些企业信息网站,我想迅速提取其中的信息。怎么写程序... 例如一些企业信息网站,我想迅速提取其中的信息。

自动抓取万维网信息的程序或脚本是网络爬虫。网络爬虫,简单来讲,就是通过程序在互联网上自动获取信息的一种技术。

如何用python爬取网站数据?

1、编写爬虫代码:使用Python编写爬虫代码,通过发送HTTP请求获取网页内容,然后使用解析库解析网页,提取所需的数据。 处理反爬措施:一些网站可能会设置反爬措施,如验证码、IP封禁等,需要相应的处理方法来绕过这些限制。

2、用python爬取网站数据方法步骤如下:首先要明确想要爬取的目标。对于网页源信息的爬取首先要获取url,然后定位的目标内容。先使用基础for循环生成的url信息。

3、selenium是一个自动化测试工具,也可以用来模拟浏览器行为进行网页数据抓取。使用selenium库可以执行JavaScript代码、模拟点击按钮、填写表单等操作。

4、安装必要的库 为了编写爬虫,你需要安装一些Python库,例如requests、BeautifulSoup和lxml等。你可以使用pip install命令来安装这些库。抓取网页数据 主要通过requests库发送HTTP请求,获取网页响应的HTML内容。

5、通过编写Python程序,可以模拟人类在浏览器中访问网页的行为,自动抓取网页上的数据。Python网络爬虫可以通过发送HTTP请求获取网页内容,然后使用解析库对网页进行解析,提取所需的数据。

怎么偷取别人网页中的一段代码

用360浏览器打开改网址,然后单击右键查看源代码。2,然后复制代码保存再修改。

这个问题其实很容易的,先讲一下原理:后台创建一个HTMLDocument类,连接至想截取的页面,属性DomDocument里保存了页面的全部HTML代码,可以随便取了,然后把代码复制到你的网页里。

浏览器打开网页,右键-》查看源代码 然后Ctrl+S保存下来 打开要保存的网页,直接Ctrl+S,选择“仅HTML”以上两种方法,选择其一即可。

网络爬虫是一种自动化的程序,可以自动地访问网站并抓取网页内容。要用网络爬虫代码爬取任意网站的任意一段文字,可以按照如下步骤进行:准备工作:需要了解目标网站的结构,以及想要爬取的文字所在的网页的URL。

第一步,我们用StrSource:= idHTTPGet(‘http:// ’);将网页代码保存在strsource变量中。

网站采集代码的介绍就聊到这里吧,感谢你花时间阅读本站内容,更多关于网站采集规则、网站采集代码的信息别忘了在本站进行查找喔。

版权说明:如非注明,本站文章均为 AH站长 原创,转载请注明出处和附带本文链接;

- 上一篇:武汉专门做网站(武汉正规制作网站公司)

- 下一篇:网站开发的流程(网站开发的流程是)

相关推荐

- 05-19建立网站,如何建立网站

- 05-19seo免费优化网站,seo网站优化软件

- 05-19网站设计模板,网站设计模板网站

- 05-19国内好的seo网站,好的seo平台

- 05-19做网站公司,做网站公司电话

- 05-19如何推广网站,如何推广网站让客户下单

- 05-19如何做网站,如何做网站网页

- 05-19广东网站seo,广东网站制作

- 05-19网站如何优化一个关键词,怎么优化一个网站关键词

- 05-19seo网站,seo网站是什么意思

取消回复欢迎 你 发表评论:

- 标签列表

- 最近发表

- 友情链接