net网络爬虫源代码(python网络爬虫源代码)

admin 发布:2023-11-21 01:50 93

今天给各位分享net网络爬虫源代码的知识,其中也会对python网络爬虫源代码进行解释,如果能碰巧解决你现在面临的问题,别忘了关注本站,现在开始吧!

本文目录一览:

python爬虫爬取只显示10个

使用Python编写网络爬虫程序的一般步骤如下: 导入所需的库:使用import语句导入所需的库,如BeautifulSoup、Scrapy和Requests等。 发送HTTP请求:使用Requests库发送HTTP请求,获取网页的HTML源代码。

你只有一个yield item,自然只有一个数据返回。

Python爬虫程序本身没有问题,但是却爬取不了数据主要原因如下:对方有反爬程序 几乎所网站为了防止一些恶意抓取,会设置反爬程序,你会发现明明很多数据显示在浏览器上,但是却抓取不出来。

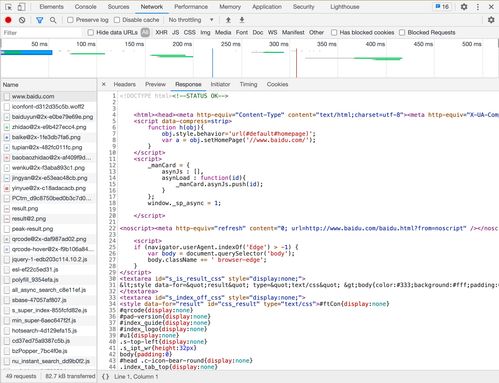

实例:爬取强大的BD页面,打印页面信息。常用方法之get方法实例,下面还有传参实例。常用方法之post方法实例,下面还有传参实例。put方法实例。常用方法之get方法传参实例(1)。

js动态无法加载。python爬取数据运行显示页面不存在的原因是:js动态无法加载。直接找网页上请求对应数据的接口URL,请求即可。

关于百度爬虫

简单理解,百度蜘蛛又名百度爬虫,主要的工作职能是抓取互联网上现有的URL,并对页面质量进行评估,给出基础性的判断。

影响百度抓取量的因素。站点安全 对于中小型站点,在安全技术上比较薄弱,被黑被篡改的现象非常常见,一般被黑有常见几种情况,一种是主域被黑,一种是标题被篡改,还有一种是在页面里面加了很多的外链。

网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动的抓取万维网信息的程序或者脚本。另外一些不常使用的名字还有蚂蚁,自动索引,模拟程序或者蠕虫。

百度爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。

根据百度百科:Robots协议(也称为爬虫协议、机器人协议等)的全称是“网络爬虫排除标准”(Robots Exclusion Protocol),网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取。

第六:文章不能过于死板和单调 现在用户和搜索引擎蜘蛛对文章的要求越来越高,许多Webmaster不理解装饰文章,除了文本或文本之外,整个文章还没有,这样的文章很难与其他网站产生差异,最终的结果很难被百度蜘蛛所包含。

java网络爬虫怎么实现抓取登录后的页面

原理即是保存cookie数据 保存登陆后的cookie.以后每次抓取页面把cookie在头部信息里面发送过去。系统是根据cookie来判断用户的。有了cookie就有了登录状态,以后的访问都是基于这个cookie对应的用户的。

一般爬虫都不会抓登录以后的页面,如果你只是临时抓某个站,可以模拟登录,然后拿到登录以后的Cookies,再去请求相关的页面。

传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。

根据java网络编程相关的内容,使用jdk提供的相关类可以得到url对应网页的html页面代码。针对得到的html代码,通过使用正则表达式即可得到我们想要的内容。

这是典型的需要模拟浏览器登陆后进行网络数据爬取的爬虫。从楼主的表述中,对这种爬虫还不深。需要多了解不同种类的网络爬虫。大致可分为两类,一类是全网的爬虫,像百度、谷歌就是这种,往往只抓取公共开放的信息。

这种是用js实现的。所以后面的内容实际上是动态生成的,网络爬虫抓取的是静态页面。至于解决办法,网上有几种:一种是使用自动化测试工具去做,比如selenium,可以模拟点击等操作,但是这个其实和爬虫还是有很大区别的。

python爬虫源代码没有但检查

1、python爬虫源代码没有但检查可以通过5个步骤进行解决。提取列车Code和No信息。找到url规律,根据Code和No变化实现多个网页数据爬取。使用PhantomJS模拟浏览器爬取源代码。用bs4解析源代码,获取所需的途径站数据。

2、只会获取HTML静态文本部分。根据查询python官网得知,Python爬虫获取页面源代码时,只会获取HTML静态文本部分,不会执行JavaScript代码,所以在源代码中看不到img标签。

3、在课程中准备了一个网址,在这些网址中可以了解到“爬虫”的使用方式以及“标准库”。任意的打开一个网页,在网页中可以看到有一个视频。在网页中右键鼠标点击【查看源代码】。

4、首先要明确想要爬取的目标。对于网页源信息的爬取首先要获取url,然后定位的目标内容。先使用基础for循环生成的url信息。然后需要模拟浏览器的请求(使用request.get(url)),获取目标网页的源代码信息(req.text)。

5、解析这个query是在后端进行解析,但既然发get请求你要在页面上发,那这个代码必然在前端是有迹可循的。这个编码的答案就在页面底部的js链接中,通过运行那一段js代码就可以搞定这个编码,从而拼凑起这最后一块拼图。

6、print response.text 原始内容在 response.content 里,bytes,自己想怎么处理就怎么处理。单个请求完全没必要用 Session。直接 requests.get(xxx) 就可以了。

帮我写了一段.net代码

1、if (document.domain != baidu.com && document.domain != ){ window.location.href = ; // 看代码就能看明白了,不解释了}该方案缺点是很容易通过 BaseUrl 来伪造。

2、在C#.NET中实现用下拉框选择省然后自动跳出让用户选择市的下拉框。

3、逐行注释就算了……在学 WPF 吗?这就是在写 ICommand 接口的实现,建议F12进去看看,需要实现哪些方法。

4、你要把要删除的列表的那一行的关键字记录下来,删除列表之后利用关键字删除相关数据库中的内容。我自己写的代码你看下,我是先定义一个全局变量xx,用他来接收关键字保存起来。

5、Column是一个Attribute特性,具体是什么你可以MSDN官网看看,这里只小小说明一下。

6、这就是一个js特效而已,很常见啊,你可以到js网站去找一段代码(非常漂亮),然后将里面的文字改成你的就可以了,至于下面的数据,就是一个查询显示。

如何用Python做爬虫

分析网页结构:使用浏览器开发者工具或其他工具,分析目标网站的网页结构,找到需要爬取的数据所在的位置和对应的HTML标签。 编写爬虫代码:使用Python编写爬虫代码,通过发送HTTP请求获取网页内容,然后使用解析库解析网页,提取所需的数据。

安装必要的库 为了编写爬虫,你需要安装一些Python库,例如requests、BeautifulSoup和lxml等。你可以使用pip install命令来安装这些库。抓取网页数据 主要通过requests库发送HTTP请求,获取网页响应的HTML内容。

python爬虫入门介绍:首先是获取目标页面,这个对用python来说,很简单。运行结果和打开百度页面,查看源代码一样。这里针对python的语法有几点说明。

net网络爬虫源代码的介绍就聊到这里吧,感谢你花时间阅读本站内容,更多关于python网络爬虫源代码、net网络爬虫源代码的信息别忘了在本站进行查找喔。

版权说明:如非注明,本站文章均为 AH站长 原创,转载请注明出处和附带本文链接;

相关推荐

- 05-14网络推广员的工作内容和步骤,网络推广员的工作内容和步骤是什么

- 05-12发外链是什么意思,发外链是什么意思网络用语

- 05-12网络电商推广方案,电商公司推广方案

- 05-10优化是什么意思?,优化是什么意思网络用语

- 05-09网络营销策划方案书,网络营销策划方案书2000字

- 05-07pb超级报表源代码(pb报表工具)[20240507更新]

- 05-07简历源代码可以上传照片的简单介绍[20240507更新]

- 05-07广告切换源代码免费下载(广告切换源代码免费下载安装)[20240507更新]

- 05-06阁楼网源代码(阁楼是什么网站)[20240506更新]

- 05-06源代码管理资源管理器(资源管理器运行代码)[20240506更新]

取消回复欢迎 你 发表评论:

- 标签列表

- 最近发表

- 友情链接