网络信息采集源代码(网站源码采集)

admin 发布:2022-12-19 19:29 119

本篇文章给大家谈谈网络信息采集源代码,以及网站源码采集对应的知识点,希望对各位有所帮助,不要忘了收藏本站喔。

本文目录一览:

高分!求高手 网站信息采集源代码或编程思路

思路:

RSS采集

相似算法

聚类

分类

(一)原理

小偷程序实际上是通过了XML中的XMLHTTP组件调用其它网站上的网页。比如新闻小偷程序,很多都是调用了sina的新闻网页,并且对其中的html进行了一些替换,同时对广告也进行了过滤。用小偷程序的优点有:无须维护网站,因为小偷程序中的数据来自其他网站,它将随着该网站的更新而更新;可以节省服务器资源,一般小偷程序就几个文件,所有网页内容都是来自其他网站。缺点有:不稳定,如果目标网站出错,程序也会出错,而且,如果目标网站进行升级维护,那么小偷程序也要进行相应修改;速度,因为是远程调用,速度和在本地服务器上读取数据比起来,肯定要慢一些。

(二)事例

以下是代码片段:

下面就XMLHTTP在ASP中的应用做个简单说明

〈%

’常用函数

’1、输入url目标网页地址,返回值getHTTPPage是目标网页的html代码

function getHTTPPage(url)

dim Http

set Http=server.createobject("MSXML2.XMLHTTP")

Http.open "GET",url,false

Http.send()

if Http.readystate〈〉4 then

exit function

end if

getHTTPPage=bytesToBSTR(Http.responseBody,"GB2312")

set http=nothing

if err.number〈〉0 then err.Clear

end function

’2、转换乱玛,直接用xmlhttp调用有中文字符的网页得到的将是乱玛,可以通过adodb.stream组件进行转换

Function BytesToBstr(body,Cset)

dim objstream

set objstream = Server.CreateObject("adodb.stream")

objstream.Type = 1

objstream.Mode =3

objstream.Open

objstream.Write body

objstream.Position = 0

objstream.Type = 2

objstream.Charset = Cset

BytesToBstr = objstream.ReadText

objstream.Close

set objstream = nothing

End Function

’下面试着调用的html内容

Dim Url,Html

Url=""

Html = getHTTPPage(Url)

Response.write Html

%〉ASP小偷入门教程.....附QQ天气小偷源代码

要做一名好的小偷有点难度:P,灵活运用XMLHTTP组件,你也可以做“小偷”

这里所说的“小偷”指的是在ASP中运用XML中的XMLHTTP组件提供的强大功能,把远程网站上的数据(图片,网页及其他文件)抓取到本地,经过各种处理后显示到页面上或者存储进数据库的一类程序。你可以通过这种小偷程序,完成过去一些似乎完全不可能实现的任务,比如说把某个站的页面偷梁换柱后变成自己的页面,或者把某个站的一些数据(文章,图片)保存到本地数据库中加以利用。“小偷”的优点有:无须维护网站,因为小偷程序中的数据来自其他网站,它将随着该网站的更新而更新;可以节省大量的服务器资源,一般小偷程序就几个文件,所有网页内容都是来自其他网站。缺点在于:不稳定,如果目标网站出错,程序也会出错,而且,如果目标网站进行升级维护,那么小偷程序也要进行相应修改;速度,因为是远程调用,速度和在本地服务器上读取数据比起来,肯定要慢一些。怎么样,听起来很神奇吧?我们现在就开始来学习一些“小偷”程序的入门知识吧!

我们拿个简单点的东西来研究一下吧,QQ网站上的天气预报程序

程序演示地址:

源码下载:

代码如下:

以下是代码片段:

〈%

On Error Resume Next

Server.ScriptTimeOut=9999999

Function getHTTPPage(Path)

t = GetBody(Path)

getHTTPPage=BytesToBstr(t,"GB2312")

End function'首先,进行小偷程序的一些初始化设置,以上代码的作用分别是忽略掉所有非致命性错误,把小偷程序的运行超时时间设置得很长(这样不会出现运行超时的错误),转换原来默认的UTF-8编码转换成GB2312编码,否则直接用XMLHTTP组件调用有中文字符的网页得到的将是乱码。

以下是代码片段:

Function GetBody(url)

on error resume next

Set Retrieval = CreateObject("Microsoft.XMLHTTP")

With Retrieval

.Open "Get", url, False, "", ""

.Send

GetBody = .ResponseBody

End With

Set Retrieval = Nothing

End Function

’然后调用XMLHTTP组件创建一个对象并进行初始化设置。

Function BytesToBstr(body,Cset)

dim objstream

set objstream = Server.CreateObject("adodb.stream")

objstream.Type = 1

objstream.Mode =3

objstream.Open

objstream.Write body

objstream.Position = 0

objstream.Type = 2

objstream.Charset = Cset

BytesToBstr = objstream.ReadText

objstream.Close

set objstream = nothing

End Function

Function Newstring(wstr,strng)

Newstring=Instr(lcase(wstr),lcase(strng))

if Newstring〈=0 then Newstring=Len(wstr)

End Function

’处理抓取回来的数据需要调用adodb.stream组件并进行初始化设置。%〉

’以下即为页面显示部分

〈%

Dim wstr,str,url,start,over,city

’定义一些需要使用到的变量

city = Request.QueryString("id")

’程序传回的ID变量(即用户选择的城市)赋给id

url=""city""

’这里设置需要抓取的页面地址,当然你也可以直接指定某个地址而不使用变量

wstr=getHTTPPage(url) ' 以下是代码片段:

获取指定页面的全部数据

start=Newstring(wstr," ")

’这里设置需要处理的数据的头部,这个变量应视不同情况而设置,具体内容可以通过查看需要抓取的页面的源代码来确定。因为在这个程序里我们需要抓取整个页面,所以设置为页面全部抓取。注意,设置的内容必须是页面内容唯一的,不可以重复。

over=Newstring(wstr," ")

’和start相对应的就是需要处理的数据的尾部,同样的,设置的内容必须是页面中唯一的。

body=mid(wstr,start,over-start)

’设置显示页面的范围

’下面就是动用乾坤挪移大法的时候了,通过replace可以用一些字符替换掉数据中指定的字符。

body = replace(body,"skin1","天气预报")

body = replace(body,"","tianqi.asp?id")

’本程序中已经完成了替换的工作,如果有其他需要的话可以继续进行类似的替换操作。

response.write body

%〉替换完需要修改的内容后,就可以把修改的内容显示在页面上了。至此程序结束

程序使用方法及结果:把上述代码去掉说明部分后保存为tianqi.asp,上传到支持ASP和XML的空间下,在浏览器中运行即可。你可以在在这个程序的基础上进行进一步的界面美化或者程序优化。

以上只是一些关于XMLHTTP组件的初级应用,实际上它还能实现的功能还有很多,比如说保存远程图片到本地服务器上,配合adodb.stream组件可以把获取来的数据保存进数据库。小偷的作用和使用范围都很广。但是不可以拿来做违法的事哦!

也许还有人要问了,这种“小偷”程序难道只是ASP的专利吗?非也,PHP通过fopen函数一样可以实现同样的效果,由于PHP本身的各种特点,写出来的小偷程序和ASP相比,在体积和执行效率上都有着明显的优势,但限于篇幅,这里就不一一说明了。

网络采集工具,可以把数据放到数据库中的

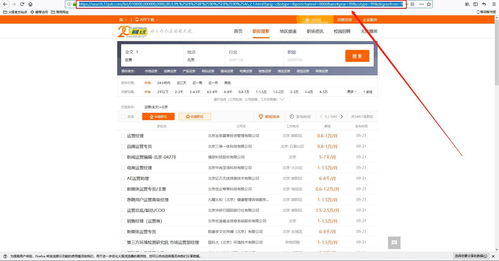

通用的采集软件都可以进行采集数据的发布,介绍三款软件,自己选择:

网络神采 共享版 采集规则自定义,可采集任意网站数据。可发布access、mssql、mysql,付费后还可发布到oracle。但网络神采共享版对采集任务数据由最大限制,好像是只能采集300条数据,用起来很不爽,其他的版本价格个人认为偏高。

火车头 免费版 采集规则配置起来略微复杂,也可发布access、sqlserver、mysql及oracle。但免费版受限较大,此方面可以参看 进行版本功能比较。

Soukey采摘 唯一一款开源免费的软件,功能与火车头网络神采类似 ,支持采集规则自定义,在此方面与火车头网络神采类似,数据库发布支持Access、sqlserver及Mysql。如果具备一定的技术基础,建议使用soukey采摘,灵活不受限制,可以针对自己的网站规则进行修正。源代码可在 下载。

我个人采集经验,采集的数据一般很难满足数据库要求规则,一般都需要进行数据加工,或者采用web方式发布数据。所以,建议选择可以带有一定数据加工的采集软件,会很方便的。

怎么用VBA或网络爬虫程序抓取网站数据

VBA网抓常用方法

1、xmlhttp/winhttp法:

用xmlhttp/winhttp模拟向服务器发送请求,接收服务器返回的数据。

优点:效率高,基本无兼容性问题。

缺点:需要借助如fiddler的工具来模拟http请求。

2、IE/webbrowser法:

创建IE控件或webbrowser控件,结合htmlfile对象的方法和属性,模拟浏览器操作,获取浏览器页面的数据。

优点:这个方法可以模拟大部分的浏览器操作。所见即所得,浏览器能看到的数据就能用代码获取。

缺点:各种弹窗相当烦人,兼容性也确实是个很伤脑筋的问题。上传文件在IE里根本无法实现。

3、QueryTables法:

因为它是excel自带,所以勉强也算是一种方法。其实此法和xmlhttp类似,也是GET或POST方式发送请求,然后得到服务器的response返回到单元格内。

优点:excel自带,可以通过录制宏得到代码,处理table很方便

。代码简短,适合快速获取一些存在于源代码的table里的数据。

缺点:无法模拟referer等发包头

也可以利用采集工具进行采集网页端的数据,无需写代码。

关于网络信息采集源代码和网站源码采集的介绍到此就结束了,不知道你从中找到你需要的信息了吗 ?如果你还想了解更多这方面的信息,记得收藏关注本站。

版权说明:如非注明,本站文章均为 AH站长 原创,转载请注明出处和附带本文链接;

相关推荐

- 05-05一键分享到微信代码(网站分享到微信代码)[20240505更新]

- 05-05人工智能系统源代码(人工智能代码下载)[20240505更新]

- 05-05易语言源代码下载(易语言下载文件源码)[20240505更新]

- 05-05网站视频弹窗代码(浏览器视频弹窗)[20240505更新]

- 05-05魔域脚本源代码(魔域互通版脚本)[20240505更新]

- 05-05androidoa开源代码(android源码网)[20240505更新]

- 05-05学校宿舍管理系统源代码(c++宿舍管理系统源代码)[20240505更新]

- 05-05miui开源代码(miui 源码)[20240505更新]

- 05-05关于软文吧的信息

- 05-05自己建网站怎样建,如何自己建网站

取消回复欢迎 你 发表评论:

- 标签列表

- 最近发表

- 友情链接